Rappel

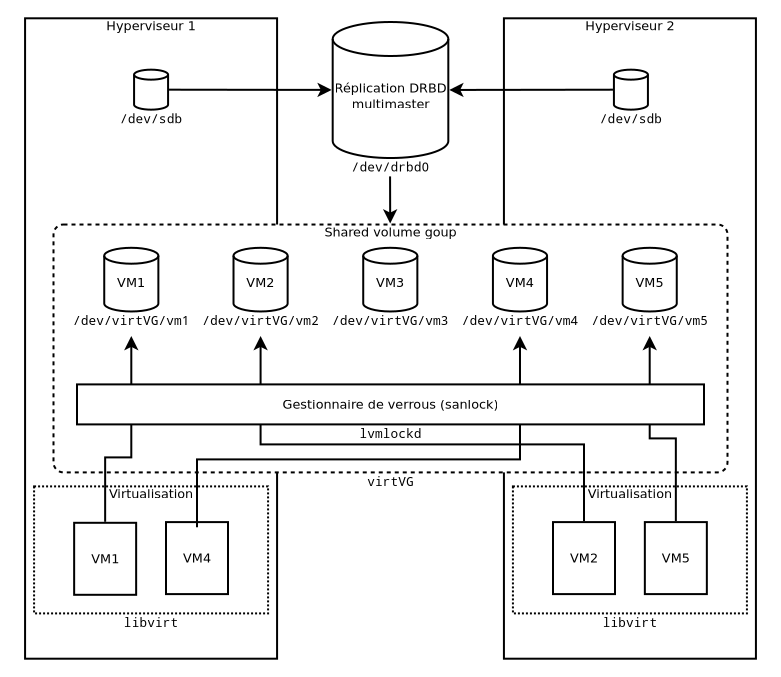

On part du besoin de pouvoir exécuter des machines virtuelles sur plusieurs hyperviseurs, et de pouvoir interchanger ces hyperviseurs comme bon nous semble, à chaud comme à froid, et de pouvoir parer rapidement à une défaillance de l'un d'eux.

En conséquence, d'un point de vue purement stockage, on a deux choses à gérer :

- Mise à disposition d'un point de stockage bloc unique à toutes les machines

- Partitionnement de ce stockage avec gestion de verrous

Pour le partitionnement, ma solution est de passer par un VG, ou volume group LVM, partagé à l'aide de sanlock. Cela consiste a disposer d'un petit LV (logical volume) appelé lvmlock dédié au sein de ce VG, dont le rôle est simplement de consigner qui utilise quoi afin que les hyperviseurs se se mettre à plusieurs pour modifier une partition et donc très probablement la corrompre. En effet les systèmes de fichiers traditionnels ne supportent pas les accès concurrentiels.

Au moment de l'activation d'un LV sur un hyperviseur, LVM va dire "Attends voir, je vais demander à mon démon (lvmlockd) si j'ai le droit d'utiliser ce LV". lvmlockd peut supporter plusieurs gestionnaires de verrous, dont sanlock, ce qui est notre cas. Il va donc lui demander "Hello, nous sommes l'hyperviseur numéro X, est-ce qu'on peut monter ce LV s'il te plaît ? J'en ai un besoin exclusif si possible", et donc le petit sanlock prend sa redingote, sa bougie et son lorgnon de clerc, et va consulter le registre des verrous maintenu dans le LV lvmlock. Ensuite, deux possibilités :

-

Le petit

sanlocktrouve un verrou actif sur le LV demandé, et il répond alors, l'air tout penaud : "Je suis vraiment navré, mais ce LV est déjà utilisé par une autre machine, je vous invite donc à réessayer plus tard.". Alorslvmlockdse voit contraint, non sans une certaine pointe de dépit, de devoir annuler l'activation du LV. Ce sont des choses qui arrivent. -

sanlockne trouve pas de verrou actif pour ce LV, et il répond tout guilleret : "C'est avec quand plaisir que je vous confirme que vous pouvez activer localement ce LV dès l'instant. Je vais vous inscrire au registre afin de signaler à mes confrères que cette ressources vous est exclusivement allouée jusqu'à nouvel ordre de votre part". Ce qu'il s'empresse de faire avec le très agréable sentiment de travail accompli, comme seuls les petits processus peuvent le faire.

Lorsque lvmlockd revient voir sanlock à la désactivation du LV, c'est avec le même entrain que sanlock marque le verrou comme relâché dans son grimoire.

Pour les migrations, au lieu d'un verrou exclusif, il est possible de solliciter un verrou partagé, qui a vocation bien sûr de ne pas durer.

La scène décrite a besoin d'un décor, c'est à dire ici d'un point de stockage bloc. Comme les verrous sont gérés au niveau du partitionnement, ce stockage ne s'encombre pas de contrôler qui peut accéder à quoi.

DRBD ou iSCSI ?

Les deux ont des avantages indéniables, ceux de DRBD étant de ne pas nécessiter un équipement tiers (donc moins cher) et de permettre la réplication des données sur les différents serveurs. Cependant un gros soucis de DRBD... c'est qu'il n'est pas fait pour faire du multi-master infini. La réplication devient vite très instable et j'ai eu plusieurs séances d'arrachage des derniers cheveux qu'il me reste à devoir réparer un split-brain, ce cas où la synchronisation est par terre et les serveurs se mettent à écrire sur le stockage indépendamment, et la réconciliation est très très compliquée. Personnellement je n'ai jamais eu la chance de pouvoir les réconcilier, j'ai du à chaque fois reconstruire la réplication en invalidant l'un de mes serveurs et en lui faisant recopier son copain.

J'en ai eu assez de gérer ça (et les accros de DRBD me diront qu'ils me l'avaient bien dit et que c'est bien fait pour ma tronche). J'ai donc songé à la possibilité de changer de camp et de disposer d'un SAN, et face au coup exorbitant de ces bestioles, m'en faire un moi-même avec les moyens du bord. J'avais en effet un NUC dans un coin et une baie Thunderbolt remplie de disques, le tout représentait mon ancien NAS, avant que j'achète un HP ProLient MicroServer d'occasion pour le remplacer.

Optimisation réseau

Mon principal frein était la vitesse du réseau. Pour doter mes VMs de disques acceptable, pensais-je, il me faut au moins une connexion 10 Gbps, sinon je me verrais contraint de limiter le nombre de VMs. Ça me rendait un peu triste, mais je gardais le projet dans un coin de ma tête.

Aggrégation de liens, une fausse bonne idée

Pendant une pause de midi, j'en ai parlé à un collègue de bureau qui a une longue expérience à la fois en stockage industriel et en auto-hébergement. Je lui ai fait part de mes craintes concernant le réseau, à quoi il m'a répondu ces paroles imbibées de sagesse :

Bah t'as qu'à faire de l'aggrégation de liens 1 Gbps, et même deux liens ça fera bien l'affaire.

J'ai trouvé l'idée très bonne et j'ai tenté le truc. Mon switch de coeur permet justement de faire de l'aggrégation. Mon NUC n'ayant qu'une seule carte réseau, j'ai résolu le problème en achetant deux simples adaptateurs USB-3 vers RJ45. Malheureusement j'ai appris que l'aggrégation de liens ne permet pas de multiplier le débit pour le genre de flux iSCSI. En effet, le principe de l'aggrégation est de répartir les paquets sur les différents liens selon plusieurs stratégies possibles (round-robin, équilibrage de charge, hashage...), mais une connexion TCP donnée sera toujours sur le même lien, et c'est précisément le cas d'iSCSI où il n'est question que d'une seule connexion TCP.

Cela dit, l'expérience n'était pas dénuée d'intérêt, et en cherchant j'ai trouvé une idée encore meilleure. Pour augmenter les performances d'un SAN, la meilleure stratégie n'est pas l'aggrégation de liens, mais la multiplication de réseaux de sockage, c'est ce qu'on appelle le multipath.

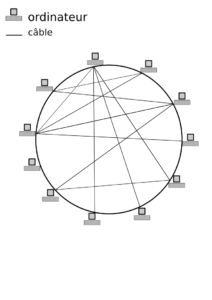

Le multipath

Faire du SAN multipath consiste à utiliser plusieurs chemins réseaux pour atteindre un point de stockage. Pour cela, le SAN doit disposer de plusieurs interfaces réseaux, chacune connectée à son propre réseau dédié. Dans l'idéal on disposerait de switchs séparés sur chacun desquels chaque hyperviseur aurait un lien. Cela permet à la fois la multiplication effective de la vitesse de tranfert et la résilience à une panne matérielle.

En pratique je n'ai pas de switch dédié. On se passera donc pour l'instant de la résilience matérielle. J'ai donc dédié deux VLANs dédiés auxquels j'ai assigné des ports de mon switch (en mode access) ce qui correspond à deux petits switchs isolés logiquement.

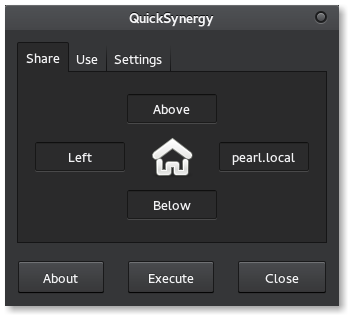

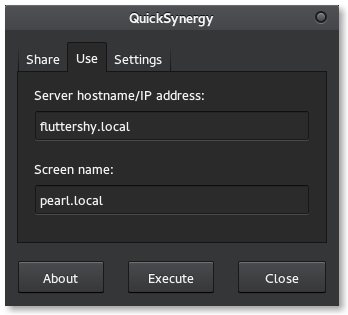

Du côté du NUC, j'ai trois interface, celle d'administration eth0 intégrée au NUC et mes deux adaptateurs USB eth1 et eth2 qui seront utilisés pour les deux réseaux de stockage. J'assigne l'adresse 10.20.5.254/24 à eth1 et 10.20.6.254/24 à eth2. Maintenant il me faut exposer le stockage sur ces deux interfaces. Le noyau Linux dispode d'un module de partage de targets SCSI contrôllable avec un outil de l'espace utilisateur appelé targetcli. Le wiki Alpine Linux dispose d'un très bon guide pour sa mise en place. Dans mon cas, j'ai créé mon backstore sur un montage RAID5 (explications dans un de mes précédents articles) avec la commande suivante :

/backstores/blockio> create block0 /dev/md0J'ai également créé non pas un portal mais deux, avec les commandes suivantes :

/iscsi/iqn.20.../tpg1/portals> create 10.20.5.254 3260

/iscsi/iqn.20.../tpg1/portals> create 10.20.6.254 3260Ce qui me donne au final un truc comme ça :

/> ls

o- / ......................................................................................................................... [...]

o- backstores .............................................................................................................. [...]

| o- block .................................................................................................. [Storage Objects: 1]

| | o- block0 ........................................................................... [/dev/md0 (8.2TiB) write-thru activated]

| | o- alua ................................................................................................... [ALUA Groups: 1]

| | o- default_tg_pt_gp ....................................................................... [ALUA state: Active/optimized]

| o- fileio ................................................................................................. [Storage Objects: 0]

| o- pscsi .................................................................................................. [Storage Objects: 0]

| o- ramdisk ................................................................................................ [Storage Objects: 0]

o- iscsi ............................................................................................................ [Targets: 1]

| o- iqn.2003-01.org.linux-iscsi.nuc.x8664:sn.a8ff70fddc94 ............................................................. [TPGs: 1]

| o- tpg1 .................................................................................................. [gen-acls, no-auth]

| o- acls .......................................................................................................... [ACLs: 0]

| o- luns .......................................................................................................... [LUNs: 1]

| | o- lun0 ..................................................................... [block/block0 (/dev/md0) (default_tg_pt_gp)]

| o- portals .................................................................................................... [Portals: 2]

| o- 10.20.5.254:3260 ................................................................................................. [OK]

| o- 10.20.6.254:3260 ................................................................................................. [OK]

o- loopback ......................................................................................................... [Targets: 0]

o- vhost ............................................................................................................ [Targets: 0]

o- xen-pvscsi ....................................................................................................... [Targets: 0]Du côté des hyperviseurs, j'ai déjà assez d'interfaces réseau, pas besoin d'adaptateurs.

eth1 |

eth2 |

|

|---|---|---|

| serveur-1 | 10.20.5.1/24 | 10.20.6.1/24 |

| serveur-2 | 10.20.5.2/24 | 10.20.6.2/24 |

Connectons nous maintenant à chacune des cibles exposées :

~# iscsiadm -m discovery -t st -p 10.20.5.254

10.20.5.254:3260,1 iqn.2003-01.org.linux-iscsi.nuc.x8664:sn.a8ff70fddc94

10.20.6.254:3260,1 iqn.2003-01.org.linux-iscsi.nuc.x8664:sn.a8ff70fddc94

~# iscsiadm -m node --targetname "iqn.2003-01.org.linux-iscsi.nuc.x8664:sn.a8ff70fddc94" --portal "10.20.5.254:3260" --login

~# iscsiadm -m node --targetname "iqn.2003-01.org.linux-iscsi.nuc.x8664:sn.a8ff70fddc94" --portal "10.20.6.254:3260" --loginUn petit lsblk confirme que deux volumes ont été ajoutés.

Maintenant il s'agit de dire à l'OS que ces deux disques sont en fait deux points d'accès au même stockage. Pour cela il faut installer le démon multipath. J'ai suivi cette doc qui explique coment l'utiliser sous debian, mais ça doit être valable partout.

Je me retrouve avec ce résultat :

~# multipath -l

mpatha (360014053221815080c24cdc938f1f56a) dm-25 LIO-ORG,block0

size=8.2T features='0' hwhandler='1 alua' wp=rw

`-+- policy='round-robin 0' prio=0 status=active

|- 6:0:0:0 sde 8:64 active undef running

`- 7:0:0:0 sdf 8:80 active undef running

~# lsblk

sde 8:64 0 8,2T 0 disk

└─mpatha 253:25 0 8,2T 0 mpath

sdf 8:80 0 8,2T 0 disk

└─mpatha 253:25 0 8,2T 0 mpath Mon volume est alors présenté sur /dev/mpatha, libre à moi maintenant d'en faire un support pour LVM. Et la procédure reprend son cours.

Conclusion

Il n'y a pas besoin d'un réseau de fou pour faire du SAN avec des VMs aux IOs raisonnables. De plus, après quelques tests à base de dd, je me suis rendu compte que les performances étaient meilleures sur mon SAN maison que sur ma partition de disque locale en cluster DRBD. En fait, ce n'est ici clairement pas le réseau qui limite, mais la vitesse de mes disques durs mécaniques.

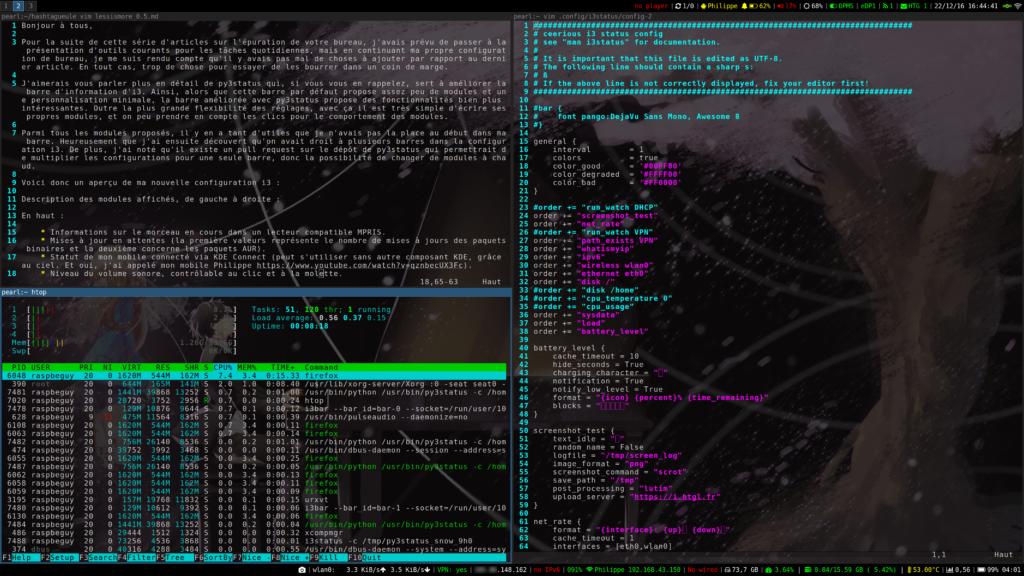

J'ai mis en place un compte sur le Fediverse pour Hashtagueule, n'hésitez pas à suivre et à commenter là-bas ainsi que sur notre salon Matrix.

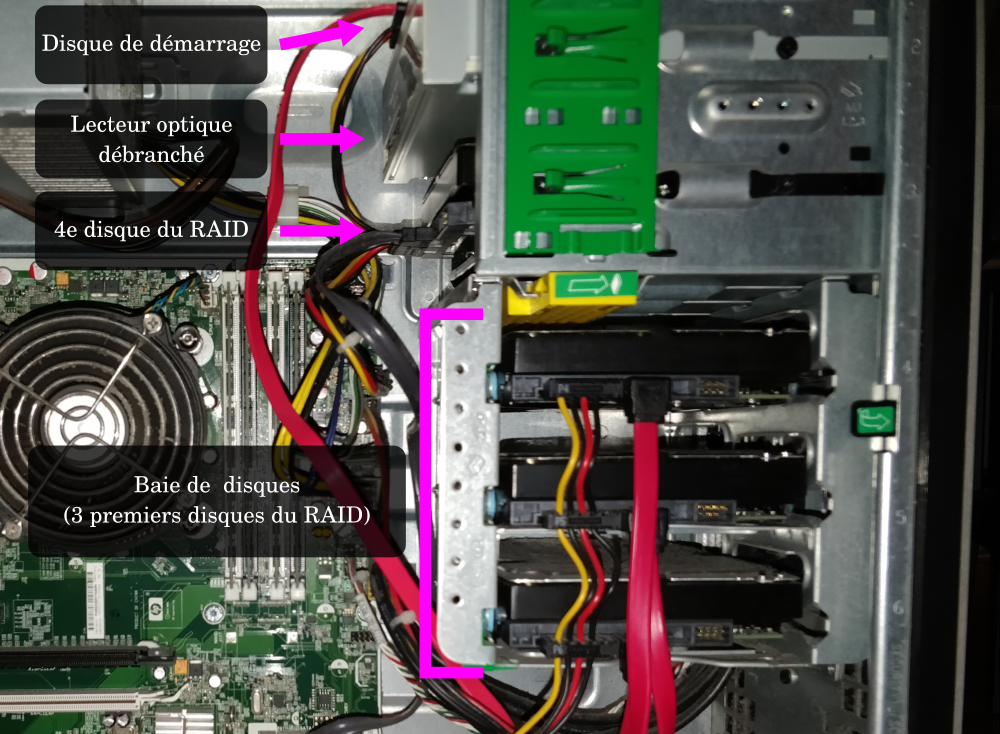

]]>Je tenais à partager une aventure amusante. Cette aventure concerne un serveur Proliant MicroServer N40L, un matériel vénérable d'une autre décennie, ressemblant un peu à une mini chaîne hifi des années 90, contenant une baie de 4 disques SATA 3,5 pouces, qui m'a été vendu par un collègue avec les 4 disques de 4 To. Les disques ont pas mal de bouteille mais les chiffres donnés par l'inspection SMART sont excellents. Du matériel idéal pour un NAS de secours.

Mon premier travail est d'ajouter un petit disque dur supplémentaire à l'emplacement prévu pour le lecteur CD/DVD afin d'y installer le système d'exploitation que je souhaite indépendant du support des données. Il existe pour ça des adaptateurs pour installer votre disque dur de façon stable.

Cela fait je souhaite m'occuper des disques destinés au RAID5 et je décide pour ça de partir sur un partitionnement GPT contenant une unique partition. Je lance donc fdisk et je constate qu'il existe déjà un paritionnement GPT, sans aucune partition cependant. Tiens, c'est marrant. Mais je ne pose pas plus de question à ce moment et je crée une première partition. Et là, fdisk m'alerte :

Partition #1 contains an ext4 signature.

Do you want to remove the signature? [Y]es/[N]o:Tiens tiens tiens, une partition cachée. Je répond donc N et par curiosité je monte la partition sans aucune difficulté. Là je trouve des noyaux Linux et des initramfs, j'ai donc affaire ici à une partition de boot.

Puis je me pose la question : Vais-je trouver les autres partitions qui se cachent sur ces disque ? Vais-je réussir à remonter le RAID qui dort ?

Je me tourne donc vers l'outil testdisk précisément conçu pour ce genre de travail. L'analyse de chaque disque révèle les partitions oubliées. Mon attention se porte particulièrement sur les partitions de type "RAID". Sur chacun des disques je sélectionne la partition en question et testdisk me propose de les inscrire dans le GPT. Je suis allé trop loin pour refuser une telle proposition. Je me retrouve donc avec 4 disques contenant chacun une partition RAID, parfaitement lisible.

Ma curiosité tourne désormais à l'excitation et j'essaye de monter le RAID à l'aide de mdadm.

mdadm --assemble --scanPremier essai infructueux, message obscur. Je regarde la sortie de dmesg et constate ceci :

md: sdc1 does not have a valid v1.2 superblock, not importing!

md: md_import_device returned -22

md: sdd1 does not have a valid v1.2 superblock, not importing!

md: md_import_device returned -22

md: sde1 does not have a valid v1.2 superblock, not importing!

md: md_import_device returned -22

md: sdb1 does not have a valid v1.2 superblock, not importing!

md: md_import_device returned -22Après un peu de recherche, je comprend que quelques métadonnées sont inexploitables (j'ignore la raison) mais peuvent être réparées sans problème, j'exécute donc :

mdadm --assemble /dev/md/debian:1 /dev/sdb1 /dev/sdc1 /dev/sdd1 /dev/sde1 --force --update=devicesizeEt bim ! Le RAID est ressuscité et j'accède à toutes les données. Je dis bien toutes : photos personnelles, informations bancaires, résultats médicaux entre autres. Et tout ça sans grande expertise en stockage !

Je n'ai bien entendu pas exploité ces données. J'ai juste prévenu le collègue qu'à l'avenir il ferait mieux de prendre le temps d'effacer ses données plus consciencieusement.

Que faut-il en retenir ? Avec l'inflation et l'augmentation des prix, le marché de l'occasion a tendance à fleurir et c'est une bonne chose ; cependant ce genre de situation est appelé à se reproduire. Il est important que chaque personne cédant du matériel stockant de l'information prenne conscience du risque de fuite de données personnelles, et donc prenne le temps d'apprendre à les effacer efficacement avant de se séparer de ce matériel.

]]>En programmation, on est souvent amené à produire un résultat ayant une forme prédéfinie, mais du contenu variable. C'est particulièrement vrai pour les sites web et blogs, dont les pages et les articles doivent respecter une mise en page uniforme et des éléments en commun, comme le menu de navigation, la charte graphique, les pieds de pages... C'est aussi vrai pour générer des fichiers de configuration, par exemple grâce à Ansible, dont on est sûr qu'ils respectent tous la même syntaxe, ce qui permet de mettre de côté le facteur humain, connu pour sa nature erratique.

La forme prédéfinie utilisée par ces techniques est appelée un template (ou modèle en français). On utilise alors un moteur de templating à qui on fournit du contenu d'un côté, un template de l'autre, et en sortie on trouvera le résultat mis en forme, notre fameuse page HTML ou fichier de configuration par exemple. On dit alors qu'on fait un rendu d'un template.

Les pythonistes utilisent principalement le moteur Jinja2 (c'est le cas pour Ansible et le moteur par défaut de Django), les PHPistes se tournent plutôt vers twig, qui a commencé en s'inspirant de Jinja2. Tous les deux ont beaucoup de fonctionnalités et disposent d'un méta-langage rappelant les langages de programmation : boucles, conditions, fonctions...

Utilisation basique

Des fonctionnalités qui sont inutiles dans certains cas d'usages. Parfois, on a uniquement envie de placer le contenu de variables à des endroits donnés, et basta. On a pas besoin de boucler dans des structures complexes ou d'utiliser des conditions. Pour ces usages basiques, vous avez probablement déjà l'outil installé sur votre distribution, il s'agit de l'outil GNU envsubst, présent dans les outils gettext (paquet gettext-base sous Debian).

J'ai utilisé envsubst lorsque j'ai développé pour mon entreprise un ensemble de scripts permettant de gérer des accès au VPN Wireguard permettant d'accéder à distance aux ressources nécessaires pour travailler. Ces scripts permettent de mettre à disposition des utilisateurs des fichiers de configuration qu'ils doivent fournir à leur client.

Je ne m'étendrai pas sur le fonctionnement de ces scripts (ni sur les considérations de sécurité nécessaires), ce sera peut-être l'objet d'un autre article. Je parlerai uniquement du templating qui y est opéré pour permettre à l'utilisateur de récupérer sa configuration, lorque la paire de clefs a été générée et l'IP interne attribuée.

À ce stade j'ai besoin de quelques variables :

$client_privkeycontenant la clef privée de l'utilisateur.$client_ipcontenant son adresse IP.$server_pubkeycontenant la clef publique du serveur.$server_endpointcontenant la clef publique du serveur.$allowed_ipscontenant les intervalles d'IP prises en charge par le tunnel.$dnscontenant l'IP du serveur DNS interne.

Mon template envsubst est le suivant (fichier userconf.tpl) :

[Interface]

PrivateKey = ${client_privkey}

Address = ${client_ip}

DNS = ${dns}

[Peer]

PublicKey = ${server_pubkey}

Endpoint = ${server_endpoint}

AllowedIPs = ${allowed_ips}

PersistentKeepalive = 25Remarquons que seules les variables $client_privkey et $client_ip varient selon l'utilisateur, et que j'aurais très bien pu directement inscrire la valeur des autres variables directement dans le fichier. Néanmoins ce code n'aurait pas été très propre ni portable.

Dans mon script, pour effectuer le rendu de ce template, j'ai les instructions suivantes :

export client_privkey client_ip server_pubkey server_endpoint allowed_ips dns

cat template/userconf.tpl | envsubst > generated_conf/${username}.confAinsi, si mon nom est raspbeguy, le fichier raspbeguy.conf contiendra mon fichier de configuration personnel, il ne me reste plus qu'à le télécharger (et à le supprimer du serveur pour des raisons de sécurité).

Si ça ne suffit pas

envsubst est vraiment très pratique car il est très simple et permet de ne pas dépendre de tout un tas de bibliothèques lourdes.

Cependant vous pouvez être amené a avoir réellement besoin d'un moteur de templating complet comme Jinja2, ne serait-ce que pour itérer des des listes d'objets par exemple. Il n'y a pas vraiment d'outil intermédiaire qui vaille le coup à ma connaissance.

Il existe un outil, présent dans les dépôts Debian, permettant de faire des rendus de templates Jinja2 directement en ligne de commande.

apt install j2cliCe paquet fournit un exécutable j2 qui accepte d'être fourni en variable suivant plusieurs méthodes, notament en piochant directement dans les variables d'environnement (comme envsubst) ou bien via des syntaxes répendues comme les format JSON, INI ou YAML. Notament, si vous voulez passez des listes ou des dictionnaires à cet outil, vous serez obligé de passer par ces syntaxes.

Cet outil vous offre toutes les fonctionnalités du moteur Jinja2.

Conclusion

Je pense qu'il est toujours préférable de se tourner en priorité vers des outils simples. Un bon projet est un projet qui ne demande pas tout l'univers en dépendances.

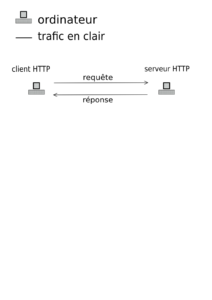

]]>Le problème

Comme vous le savez, lorsqu'un navigateur souhaite obtenir une page d'un site internet, il fait ce qu'on appelle une requête HTTP. Cette requête contient entre autres un certain nombre d'en-têtes, dont un qui s'appelle Host.

Cet en-tête permet de signaler au serveur web quel est le site internet qui est interrogé, dans le cas où ce serveur web sert plusieurs sites à lui tout seul.

Par exemple, pour consulter Hashtagueule, votre navigateur emet une requête HTTPS sur le port 443 du serveur Hashtagueule avec un Host qui ressemble à ça :

Host: hashtagueule.frLe serveur regarde alors la liste des sites qu'il peut servir, il trouve le bon, et il renvoie le contenu demandé par la requête.

Ce que j'ignorais jusqu'alors, c'est que cet en-tête peut contenir de manière facultative le numéro de port distant. Pour Hashtagueule, cela donnerait :

Host: hashtagueule.fr:9091Je ne comprends pas très bien pourquoi le numéro de port peut être inclus dans cet en-tête. D'autant plus que dans la pratique, les navigateurs incluent ce numéro de port dans certains cas seulement. D'après mes tests sous Firefox et curl (sans forcer l'en-tête avec l'option -H) :

- Si le numéro de port correspond au port standard du protocole (80 pour HTTP, 443 pour HTTPS), alors ce numéro de port est omis de l'en-tête (et même si vous ajoutez ce numéro de port dans votre barre d'URL).

- Si le numéro diffère du port standard, il est inclus dans l'en-tête.

Autrement dit, pour l'immense majorité des sites internet, ce numéro de port n'est jamais inclus. Ça explique comment on peut passer à côté de cette réalité.

Certains serveurs web comme nginx vous évitent de vous en soucier et font abstraction de ce numéro de port lorsqu'ils font la correspondence entre requête et site.

Par contre, d'autres comme HAProxy ne le font pas par défaut, et donc si vous n'êtes pas conscient de cela, vous risquez d'avoir des problèmes.

L'apprentissage par l'échec

J'utilise le programme Transmission sur mon serveur à la maison en mode "headless" (c'est à dire sur un serveur distant, avec une interface web). Celui-ci écoute d'habitude sur un port non standard, le port 9091. Cependant je l'ai placé derrière mon preverse proxy qui s'avère être HAProxy, ainsi tous mes sites HTTPS utilisent le port standard 443. Donc pour accéder à l'interface (et à l'API) de Transmission dans mon cas, il faut passer par le port standard 443.

tremotesf est une application Android qui se connecte à l'API de votre instance Transmission pour vous permettre de la contrôler, avec une interface sympa.

C'est en utilisant cette application que j'ai découvert le soucis : toutes les requêtes émises par cette application ont un en-tête Host contenant le numéro de port, qu'il soit standard ou non. Dans mon cas, donc, cela donnait ça :

Host: transmission.example.com:443N'ayant pas prévu le coup, mon HAProxy était configuré pour mettre en correspondance Transmission avec le Host transmission.example.com, mais ne savait que faire avec le Host transmission.example.com:443.

La solution

Elle tient en une seule ligne, à placer dans la section Frontend :

http-request replace-header Host ([^:]+) \1Cette directive dit simplement de supprimer les deux points et tout ce qui se trouve après, c'est à dire le numéro de port. On retombe donc bien sur un Host sans numéro de port.

Ainsi on ne m'y reprendra plus.

]]>Quand nous avons créé le site Hashtagueule, nous voulions éviter de parler d'argent dessus. À titre personnel, je pense qu'on parle bien assez d'argent partout ailleurs et je voulais un petit coin de paradis qui ne soit pas pollué par de basses questions matérielles.

Je vais faire une exception aujourd'hui, car oui, héberger un site coûte de l'argent.

Rassurez-vous, nous ne sommes pas au bord de l'extinction du blog. Cependant, le site est porté par deux personnes, Motius et moi-même, et alors que lorsque nous avons commencé à écrire, nous étions jeunes et insouciants, nous commençons désormais à avoir des vies de familles. Cela veut dire que nous avons plus de choses plus importantes à nos yeux que les finances du blog.

Le serveur hébergeant Hashtagueule est chez OVH et coûte une soixantaine d'euros par mois (mais nous l'utilisons également pour beaucoup d'autres choses). Ces frais pourraient être réduits en rappatriant le site directement à domicile, ce qui sera fait dès lors que la fibre sera installée chez moi...

J'ai donc décidé d'ouvrir une page Liberapay pour permettre aux lecteurs de contribuer financièrement au blog.

Surtout, gardez à l'esprit que nous ne souhaitons pas recevoir d'argent pour écrire des articles. C'est une activité récréative, c'est important pour nous qu'elle reste bénévole. Cet argent est uniquement destiné au maintien de l'infrastructure du site.

Vous trouverez notre page de don dans la barre latérale ou à la fin de cet article.

Je vous remercie et ferme maintenant cette parenthèse "finance".

]]>Depuis quelques semaines, on me rabache les oreilles à propos d'un truc qui n'est pas le web. Bien entendu, beaucoup de choses ne sont pas le web. Voici une liste non exhaustives de choses qui ne sont pas le web :

- un gâteau au chocolat

- l'Arc de Triomphe

- des chaussures de sport

- la révolution industrielle

- la COVID-19

On pourrait aller bien plus loin si on voulait.

En fait, c'est l'un des premiers éléments de présentation de Gemini : ce n'est pas le web. Mais alors qu'est-ce que c'est ?

Ce qui n'est pas le web

Au début des années 90, alors qu'Internet avait été inventé, mais alors utilisé en grande partie par des bandes d'universitaires boutonneux pour faire des trucs d'intellos, plusieurs idées ont germé en parallèle dans le monde pour mettre au point un moyen de consulter des informations sous forme de pages navigables.

L'une de ces idée venant d'Europe est le protocole HTTP, couplé au format HTML, qui forment ce qu'on appelle aujourd'hui le web.

Ce qu'on sait moins, c'est que d'autres protocoles ont vu le jour à peu près en même temps, notamment le protocole Gopher, mis au point aux États-Unis. Ce protocole était vraiment minimaliste (même si HTTP l'était presque autant à l'époque) et se couplait le plus souvent avec du contenu en texte simple.

Au bout d'un certain temps, le web a fini par l'emporter, notament à cause de l'intégration d'image dans les documents HTML, et le monde Gopher s'est réduit à peau de chagrin et est complètement délaissée par l'industrie.

Certains irréductibles continuent de servir des sites Gopher. L'argument de ces derniers des Mohicans, c'est la légèreté des sites Gopher par rapport aux sites web d'aujourd'hui : un site Gopher n'est que du texte : pas d'image, pas de mise en forme, pas de distractions. Ça fonctionne bien pour présenter de l'information austère.

La relève

Gemini est une initiative récente pour tenter de relancer cette contre-culture Internet. Il s'agit à la fois d'un protocole au même titre que HTTP et Gopher, et d'un format de mise en forme, au même titre que HTML et le... texte simple. Sur la page du projet (côté Gemini, gemini://gemini.circumlunar.space/), il se présente comme "plus lourd que Gopher, plus léger que le web". Le but ici est de prioriser la légereté, mais également la vie privée, en prohibant les mécanismes classiques de traçage utilisés sur le web.

Côté protocole, à l'inverse de HTTP qui compte en moyenne une bonne grosse marmite d'en-têtes (y compris ceux concernant les fameux cookies), Gemini ne s'autorise qu'un seul en-tête, permettant de préciser le type de contenu servi. Une requête Gemini ne contient pas de verbe type GET, POST, etc. Uniquement l'URL. Et c'est à peu près tout ce qu'on peut en dire. Ah si, le chiffrement TLS des pages est obligatoire, et les certificats sont pour la plupart auto-signés, dans un fonctionnement TOFU (Trust On First Use). Un choix pas anodin, on en reparlera.

TOFU sur Wikipedia (en anglais)

Côté format de contenu, Gemini privilégie le Gemtext, un format mis au point par le projet dérivé de Markdown. Enfin, un Markdown vraiment dépouillé. La différence avec le Markdown est l'interdiction des liens dans un paragraphe en les déplaçant sur leur propre ligne bien isolée (comme les liens dans le présent article) et l'impossibilité d'intégrer des images autrement qu'en mettant des liens normaux. C'est un peu spartiate mais c'est quand même un peu plus beau que du texte brut. Les détails du Gemtext sont à retrouver sur la page Gopher du projet.

Naviguer sur Gemini

Si on a du contenu navigable, alors il faut un navigateur. Non, vous ne pourrez pas aller sur un site Gemini (les gens du milieu aiment bien les appeler des capsules) avec votre Firefox. Ou alors si, mais en passant par une passerelle qui convertit le contenu Gopher en HTTP/HTML.

Il existe plusieurs navigateurs Gemini. Les deux qui ont retenu mon attention sont :

- Lagrange : c'est un navigateur graphique très esthétique. Je le trouve visuellement très plaisant.

- amfora, en ligne de commande.

Ce que je pense de Gemini

Le web a bien des défaut. Il vous traque, il consomme beaucoup de ressources. Et la plupart du temps, lorsque que vous essayez de ne prendre que ce qui vous intéresse en éliminant les ressources inutiles, vous finissez avec une page immonde et vraiment pas agréable.

L'idée d'un web basé sur du markdown et laissant le soin de la mise en page au le client est présente dans ma tête depuis un certain temps. Quand on m'a parlé de Gemini, j'ai été immédiatement intéressé.

Cependant je suis contrarié par plusieurs points.

Pour moi, même si je suis vraiment satisfait de ce minimalisme, je pense qu'il est complètement inutile de créer un nouveau protocole. À mon sens, il aurait été bien plus intéressant de développer le format Gemtext sur HTTP, et de mettre au point des navigateurs (ou en adapter des existants) pour y mettre un mode ou il n'interprète qu'un nombre bien restraints d'en-têtes.

Développer Gemini sur du HTTP, cela aurait permis deux choses :

- Pouvoir utiliser les infrastructures existantes pour relayer du Gemini. Il n'existe pas encore d'équivalent à HAproxy pour Gemini.

- Rendre les navigateurs existants compatibles, quitte à avoir une mise en page un peu dégueu.

Parlons maintenant des certificats. Selon les créateurs de Gemini, le système de validation des certificats par des autorités de certification est dangereux, car il suffit qu'une autorité soit mise à mal pour corrompre l'ensemble des sites qu'elle a certifié.

Oui, le système des autorités de certification n'est pas parfait. Mais pour la navigation sur des serveurs a priori inconnu, cela reste mille fois mieux que le principe TOFU.

Le mode TOFU est celui adopté par SSH : à la première connexion, la signature de la connexion est enregistrée et pour les connexions suivantes, on vérifie que la signature n'a pas changé, et si elle a changé, on affiche un avertissement.

Pour SSH, cela fait sens. On ne se connecte pas à n'importe quel serveur : normallement, on vérifie que la signature de la première connexion est effectivement la bonne car il s'agit de nos propres serveurs ou ceux d'un ami/collègue. En bref, avec SSH, si on fait les choses bien, on n'accepte pas aveuglément un certificat. Pour la navigation, on est susceptible de pouvoir se connecter sur n'importe quel serveur proposant un serveur Gemini, tenu par des gens inconnus. Là il n'est plus question de pouvoir vérifier quoi que ce soit. Il faut juste espérer que la première connexion a été bonne, et croiser les doigts. Je sais pas pour vous, mais moi ça me met très mal à l'aise.

Nous avons quand même franchis le pas et à titre d'expérience, nous vous proposons notre capsule Gemini, pour ce que cela vaut, sur gemini://hashtagueule.fr.

Merci de votre attention.

]]>On pourrait débattre longtemps sur la décision du déploiement de la 5G. On le fera probablement, mais pas tout de suite. Là maintenant c'est à propos de santé que je vais vous parler. Et non, pas de rapport avec la COVID-19.

Le gouvernement travaille depuis un certain temps sur un projet qu'on appelle la Platerforme de Données de Santé (en anglais Health Data Hub). L'idée derrière tout ça est de centraliser et rationaliser les informations de santé de toute la France, ce qui passe entre autres par y mettre un petit coup d'intelligence artificielle.

Dans l'idée ça pourrait être une bonne idée, cela permettrai d'encadrer les décisions médicales, de faciliter la recherche et de suivre la santé de la population au niveau national. C'est d'ailleurs sur cette infrastructure que s'appuie l'outil StopCovid, dans les condition et l'absence de succès que nous connaissons.

C'est un projet ambitieux sans aucun doute. C'est à ce stade que la route devient glissante. En effet il était prévu, jusque tout récemment, que cette platerforme repose sur Microsoft Azure, donc des données américaines et une entreprise suhette à nombre controverses.

Plusieurs remarques doivent venir à l'esprit :

- Lobbying : L'État français ne respecte pas le procédé règlementaire pour ce projet, qui impose de passer par un cahier des charges et un appel d'offre publique.

- Communication : Par le choix d'une plateforme étrangère et non-européenne, l'État statue que la France et l'Europe n'ont pas la compétence pour assurer techniquement un tel projet.

- Souveraineté numérique : Les données seraient donc sous la juridiction américaine, donc non protégées par le RGPD et soumises à toutes sortes d'atrocités juridiques comme le Cloud Act et le Patriot Act, qui permettent en gros à l'État américain de faire ce qu'il veut avec ces données.

- Vulnérabilité des données : Rien ne permettrait de vérifier que Microsoft ne fait pas d'usage commercial de ces données.

- Économie : Encore une fuite d'argent publique vers un pays étranger qui n'en a pas besoin et sans véritable raison.

La décision avait provoqué un soulèvement tant au niveau des associations et organismes de protection de la vie numérique que de l'industrie hexagonale. Octave est fou de rage. Une pétition au Sénat a été lancée. Des sourcils ont été froncés.

Il semblerait que la polémique ait porté quelques fruits et que l'État envisage un rétropédalage.

On a donc l'air de s'éloigner du ravin, mais on a bel et bien senti le vent du boulet. Vous pouvez toujours signer la pétition, juste au cas où.

]]>Aujourd'hui, je veux vous parler d'une bibliothèque Python3 :

jsonpath2.

Un peu de contexte

Il s'agit d'une petite bibliothèque de code qui permet de filtrer des données au format JSON. Vous me direz, on peut déjà faire ça avec des petites fonctions utilitaires, quelques coups de liste en compréhension. Il y a bien sûr un grand nombre de choses que la bibliothèque ne permet pas de faire, on y reviendra, mais concentrons-nous d'abord sur ce qu'elle permet, et les avantages qu'elle procure.

Pour cela, je vous propose tout simplement de vous présenter l'exemple que j'ai eu à traiter.

Un exemple

Supposez que vous ayez comme moi une application qui écrive un journal

d'exécution au format JSON, dont les entrées sont relevées périodiquement par

un ELK, et que vous ayez à analyser

une journée complète, ce qui vous donne environ 50 Mo de logs compressés en

gzip, et 700 Mo une fois décompressés. Vous rentrez ça dans un interpréteur

ipython et bam, 3 Go de RAM supplémentaires utilisés. (Dans les cas où vous

utilisez beaucoup de mémoire dans ipython, rappelez-vous que celui-ci stocke

tout ce que vous taper dans des variables nommées _i1, _i2... et les

résultats de ces opérations dans les variables correspondantes _1, _2, ce

qui peut faire que votre interpréteur consomme une très grande quantité de

mémoire, pensez à la gérer en créant vous-même des variables et en les

supprimant avec del si nécessaire. Mais je m'égare.)

Il peut y avoir plusieurs raisons qui font que ces logs ne seront pas complètement homogènes :

- vous avez plusieurs applications qui fontionnent en microservices ;

- les messages comportant des exceptions ont des champs que les autres messages plus informatifs n'ont pas ;

- etc.

Toujours est-il que pour analyser ce JSON, vous pouvez être dans un beau pétrin au moment où vous vous rendez compte que chacune des petites fonctions utilitaires que vous écrivez doit :

- gérer un grand nombre de cas ;

- gérer des cas d'erreur ;

- être facilement composable, même pour les cas d'erreur.

Je ne dis pas que ce soit infaisable, et il m'est arriver de le faire ainsi pour certaines actions plutôt qu'en utilisant JsonPath.

Pour l'installation, c'est comme d'habitude dans le nouveau monde Python :

# dans un virtualenv Python3

pip install jsonpath2Cas pratiques

Exemple de code n°1

Par exemple, si je souhaite obtenir toutes les valeurs du champ message où

qu'il se trouve dans mon JSON, je peux le faire ainsi :

import json

from jsonpath2.path import Path as JsonPath

with open("/path/to/json_file/file.json", mode='r') as fr:

json_data = json.loads(fr.read())

pattern = "$..message"

ls_msg = [

match.curent_value

for match in JsonPath.parse_str(pattern).match(json_data)

]La variable qui nous intéresse ici, c'est pattern. Elle se lit ainsi :

$: racine de l'arbre analysé..: récursion sur tous les niveauxmessage: la chaîne de caractères recherchés

Avantage

Le premier avantage que l'on voit ici, c'est la possibilité de rechercher la valeur d'un champ quelle que soit la profondeur de ce champ dans des logs.

Exemple de code n°2

On peut aussi raffiner la recherche. Dans mon cas, j'avais une quantité de

champs "message", mais tous ne m'intéressaient pas. J'ai donc précisé que je

souhaitais obtenir les champs "message" seulement si le champ parent est, dans

mon cas, "_source" de la manière suivante :

pattern = "$.._source.message"Par rapport au motif précédent, le seul nouveau caractère spécial est :

.: permet d'accéder au descendant direct d'un champ.

Avantage

L'autre avantage qu'on vient de voir, c'est la possibilité de facilement rajouter des contraintes sur la structure de l'arbre, afin de mieux choisir les champs que l'on souhaite filtrer.

Exemple de code n°3

Dans mon cas, j'avais besoin de ne récupérer le contenu des champ "message"

que si le log sélectionné était celui associé à une exception, ce qui

correspondait à environ 1% des cas sur à peu près 600 000 entrées.

Le code suivant me permet de sélectionner les "message" des entrées pour

lesquelles il y a un champ "exception" présent :

pattern = "$..[?(@._source.exception)]._source.message"Il y a pas mal de nouveautés par rapport aux exemples précédents :

@: il s'agit de l'élément couramment sélectionné[]: permet de définir un prédicat ou d'itérer sur une collection?(): permet d'appliquer un filtre

Avantage

On peut facilement créer un prédicat simple pour le filtrage d'éléments, même lorsque l'élément sur lequel on effectue le prédicat n'est pas le champ recherché in fine.

Au sujet de jsonpath2

Si vous êtes intéressé par le projet, je vous mets à disposition les liens suivants (ils sont faciles à trouver en cherchant un peu sur le sujet) :

- un article présentant le filtrage JSON d'après l'équivalent XPath pour XML ;

- le lien vers PyPI de la bibliothèque

- le lien GitHub de la bibliothèque

- le lien vers une implémentation JavaScript populaire de JsonPath.

jsonpath2 utilise le générateur de parseur ANTLR,

qui est un projet réputé du Pr. Terence Parr.

Inconvénients

Parmi les prédicats qu'on peut faire, on peut tester si une chaîne de caractères est égale à une chaîne recherchée, mais les caractères qu'on peut mettre dans la chaîne recherchée sont assez limités : je n'ai pas essayé de faire compliqué, seulement de rechercher des stacktraces Python ou Java, qui ont peu de caractères spéciaux.

Il paraît qu'on peut effectuer des filtrages plus puissants avec une fonctionnalité supplémentaire que je n'ai pas présentés parce que je n'ai pas pris le temps de l'utiliser :

(): s'utilise afin d'exécuter des expressions personnalisées.

J'espère que tout ceci pourra vous être utile. Je vous recommande notamment de tester vos motifs sur un petit jeu de données, on peut facilement faire des bêtises et consommer beaucoup de mémoire et pas mal de temps sans cela.

Joyeux code !

Motius

]]>Aujourd'hui, je veux vous parler des dictionnaires en Python, et notamment de leur — relativement — nouvelle propriété d'ordre.

TL;DR: les considérations concernant les dictionnaires ordonnés tourne autour des performances. On oublie de mentionner que cela facilite le débogage, mais que cela peut aussi cacher un bogue dans l'implémentation d'un algorithme, raison pour laquelle j'ai écrit le fragment de code ci-dessous.

Un peu de contexte

Si l'on en croit ce thread StackOverFlow, les clefs d'un dictionnaire dans Python3 depuis sa version 3.6 sont de facto ordonnées dans l'implémentation CPython (dans l'ordre d'insertion), et Python3 dans sa version 3.7 standardise cet état de fait, ce qui veut dire que les autres implémentations (PyPy, Jython...) devront s'aligner afin de correctement implémenter le nouveau standard, pour assurer la compatibilité du code entre "interpréteurs". (Je mets le lien StackOverFlow parce qu'il en contient d'autres vers la liste de diffusion de courriel, etc.)

Si vous vous demandez ce qui a amené à cet état de fait, je vous recommande la vidéo suivante, par le curieux Raymond Hettinger.

Avec ça, vous aurez des éléments pour évaluer la pertinence des dictionnaires ordonnées en Python.

Notez, pour ceux qui n'ont pas regardé la documentation, que Python3 met à disposition un OrderedDict déjà disponible dans les versions antiques, antédiluviennes, je veux dire celles pré-3.4 (oui, je trolle, mais à peine).

Le problème

Voyons un peu le contexte des deux problèmes qui m'ont amené à écrire cet article.

Scénario 1

J'étais en train de déboguer un logiciel, appelons-le Verifikator, qui faisait des appels API afin de vérifier des données en bases. Il se trouve que les résultats de Verifikator étaient aléatoires. De temps en temps, il retournait les bons résultats, i.e. il indiquait que certaines données en base étaient invalides, et de temps en temps, Verifikator n'indiquait pas d'erreur, alors qu'on pouvait vérifier a la mano qu'il y avait effectivement une erreur en base. Pour faire simple, la raison pour laquelle Verifikator n'était pas déterministe, c'est qu'il dépendait de l'ordre d'un dictionnaire dont la donnée provenait de l'API de la base de données. Vous comprenez que j'exagère quand je dit que Verifikator n'était pas déterministe, il l'est heureusement, puisqu'il s'agit d'un système informatique, et qu'on néglige les rayons cosmiques et les bogues système.

Je me permet de rappeler à ceux d'entre vous qui s'étonnent de ce comportement erratique de Verifikator que j'étais en train de le déboguer (qui plus est, j'avais seulement participé à sa conception, pas à son implémentation).

Verifikator tourne en Python3.5, si l'on avait utilisé une version supérieure, on n'aurait pas eu ce problème, notamment, Verifikator aurait soit systématiquement planté, soit systématiquement fonctionné. Ç'eût été mieux afin de pouvoir localiser le bug par dichotomie, je vous avoue que mon état de santé mentale se dégradait à vu d'œil lorsque j'ai commencé à observer ce comportement aléatoire, en cherchant à localiser les lignes fautives par dichotomie.

Je reviens un instant sur cette histoire de dichotomie pour bien faire sentir à quel point c'est fatiguant. Imaginez un peu, vous essayez de déterminer un point A où le programme est dans un état valide et un point B dans lequel l'état est invalide, puis vous regardez un nouveau point C "au milieu", afin de savoir si ce point C est le nouveau point valide A' ou bien le nouveau point B' pour l'itération suivante. Le problème, c'est que parfois vous pensez que l'état du programme est valide à ce point C, mais que ce n'est pas vrai en général. Vous continuez donc à itérer entre C et B, alors que le problème se trouve entre A et C.

Vous comprenez pourquoi j'apprécie fortement le fait que les dictionnaires soient ordonnés pour le débogage.

Mais. Comme vous imaginez, il y a un mais. Parce qu'il n'y a pas que des avantages aux dictionnaires ordonnés. C'est le sujet du second scénario.

Scénario 2

Dans d'autres circonstances, j'ai déjà écrit — j'étais l'auteur du code cette fois-là, contrairement à Verifikator — un algorithme qui ne fonctionnait que si le dictionnaire sur lequel il tournait était ordonné. J'utilisais Python3.6 à l'époque, et par conscience professionnelle, j'ai compilé les versions 3.4 à 3.7 de Python afin de vérifier que les tests étaient corrects avec ces interpréteurs. Quelle ne fut pas ma surprise quand je m'aperçus que ce n'était point le cas. Ce n'était même pas le nouvel Python3.7 encore en bêta qui posait problème, mais les version 3.4 et 3.5. J'ai donc réécrit cet algorithme afin qu'il ne dépende plus de l'ordre du dictionnaire d'entrée (très simplement en construisant un OrderedDict à partir du dictionnaire et d'une liste correctement triée).

Conséquences

À l'époque, je n'avais pas rajouté de code pour tester les fonctions de service du second programme, je m'assurai qu'il fonctionnait avec les 4 versions mineures de Python3 pour lesquelles je développais le programme.

J'ai fait les choses différemment cette fois, puisque j'ai codé cette fonction, qui randomise les clefs d'un dictionnaire plat (fonction non récursive sur d'éventuels dictionnaires en valeurs du dictionnaire passé en argument).

import random as rnd

def shuffle_dict_keys(d: dict) -> dict:

"""shuffle the keys of a dictionary for testing purposes now that

Python dictionaries are insert-ordered. Does not compute inplace.

Does not work recursively.

"""

res = {}

l = list(d)

rnd.shuffle(l)

for k in l:

res[k] = d[k]

return resJ'avais en tête cette planche XKCD en écrivant ce code. Non pas que je préfère l'ancien comportement, mais que pouvoir y souscrire de manière optionnelle me permet d'avoir des tests de meilleure qualité, et qu'il a donc fallu queje trouve un contournement afin de retrouver l'ancien comportement dans les cas de tests.

Conclusion

De manière générale, je suis assez content que les dictionnaires soient ordonnés, mais je ne m'attendais pas à rencontrer de tels écueils, notamment puisque la majorité des conversations que j'avais lues sur le sujet s'attardaient sur les performances de cette nouvelle implémentation, et non sur ce genre de considérations.

Joyeux code !

Motius

]]>Aujourd'hui, je vous propose un micro tutoriel pour créer un enum dynamiquement en Python.

Je vous accorde qu'on ne fait pas ça tous les jours, c'est d'ailleurs la première fois que je suis tombé sur ce cas.

Un peu de contexte

En général, un enum, ça ressemble à ça en Python :

class MonEnumCustom(enum.Enum):

"""docstring

"""

VALIDATION = "VALIDATION"

SEND = "SEND"Si l'enum contient un grand nombre de valeurs, chacune correspondant à un état, on peut aisément les formater avec un programme, afin d'écrire un enum comme ci-dessus.

Ça fait simplement un enum comme ci-dessus, mais en plus gros :

class MonEnumCustom(enum.Enum):

"""docstring

"""

VALIDATION = "VALIDATION"

SEND = "SEND"

COMMIT = "COMMIT"

REVIEW = "REVIEW"

... # une centaine d'états supplémentaires disponiblesMais que faire quand on récupère les valeurs dynamiquement depuis un appel à une API, qui retourne l'ensemble des états possibles sous forme d'une collection, comme ceci :

>>> ls_remote_states = fetch_all_states(...)

>>> print(ls_remote_states)

[

"VALIDATION",

"SEND",

"COMMIT",

"REVIEW",

...

]et que l'on souhaite créer un enum à partir de ladite collection afin d'écrire du code qui dépendra de valeurs d'états prise dans l'enum comme ci-dessous ?

# pseudo-code

ls_remote_states = fetch_all_states(...)

MonEnumCustom = create_enum_type_from_states(ls_remote_states)

# dans le code

if state is MonEnumCustom.VALIDATION:

print("En cours de validation")

elif state is MonEnumCustom.COMMIT:

...

else:

raiseC'est le sujet de la discussion qui suit, qui va présenter les options disponibles, et quelques considérations quant à leurs usages.

Le scénario

Je souhaitais pouvoir m'interfacer avec un service qui définit un grand nombre (un peu plus d'une centaine) de constantes qu'il me renvoie sous forme d'une collection de chaînes de caractères. Trois choix s'offraient ainsi à moi :

-

utiliser les constantes telles quelles dans une collection (

list,dict...)Avantages :

- rapide & facile

Inconvénients :

- sémantiquement pauvre

- la liste des états valides n'est jamais écrite dans le code

-

faire un copié collé et du formatage (avec vim, c'est facile et rapide)

Avantages :

- rapide & facile

- l'intégralité des valeurs connues de l'

enumpeuvent être lues dans le programme à la seule lecture du code

Inconvénients :

- duplique un

enumdont je ne suis pas responsable

-

générer dynamiquement l'

enumAvantages :

- résout les inconvénients des solutions précédentes

- évite la duplication de code inutile.

Il arrive assez souvent que l'on doive définir un même

enumà plusieurs endroits dans un système informatique, par exemple en base de donnée dans Postgre, puis en Java / Python, et enfin en Typescript si vous faites du développement sur toute la stack. Mais dans ce cas-ci, j'aurais redéfini un enum sans que mon code ne soit la source d'autorité sur celui-ci, ce qui contrevient au principe du Single Source of Truth, c'est donc plus gênant que le simple problème de duplication de code. - Plus facile à adapter lors de l'évolution de l'

enum. Ce dernier point est vrai dans mon cas où j'ai l'assurance que l'API ne fera qu'augmenter les états et n'invalidera jamais un état existant. Dans le cas contraire, il faudra changer les fonctions qui utilisent les états définis dans l'enum, avec ou sans la génération d'enumautomatique.

Inconvénients :

- à nouveau, la liste des états valides n'est jamais écrite dans le code

- Un tantinet plus long, surtout si tout ne va pas sur des roulettes du premier coup.

Et si je mentionne les roulettes, c'est que vous imaginez bien que ça n'a pas marché du premier coup (sinon je n'écrirais pas cet article).

La théorie

Selon la documentation officielle, il suffit de passer 3 paramètres à la fonction type afin de créer une classe dynamiquement.

Si vous voulez mon avis, on est là dans la catégorie des fonctionnalités de Python vraiment puissantes pour le prototypage (à côté de eval et exec, même si ces derniers devraient être quasiment interdits en production).

Chouette, me dis-je en mon fort intérieur, ceci devrait marcher :

# récupération du dictionnaire des valeurs

d_enum_values: dict = fetch_all_states(...)

# création dynamique de l'enum

MonEnumCustom = type("MonEnumCustom", (enum.Enum,), d_enum_values)La pratique

Ne vous fatiguez pas, ça ne marche pas. La solution que j'ai trouvée est un contournement dégoûtant (dû justement au module enum de Python).

Je contourne les problèmes de création d'enum à l'aide d'un mapper qui ressemble à ça :

class EnumMappingHelper(dict): # héritage pour contourner type

def __init__(self, mapping: dict = None):

self._mapping = mapping

def __getitem__(self, item):

if item == "_ignore_": # contournement d'enum

return []

return self._mapping[item]

def __delitem__(self, item):

return item # contournement d'enum

def __getattr__(self, key): # Accès au clefs de l'enum par attribut

return self._mapping[key]

@property

def _member_names(self): # contournement d'enum

return dict(self._mapping)

enum_mapping = EnumMappingHelper(d_enum_values)

MonEnumCustom = type("MonEnumCustom", (enum.Enum,), enum_mapping)Je m'en sors donc en torturant un peu un classe personnalisée que j'appelle EnumMappingHelper afin que celle-ci se comporte d'une façon qui soit acceptable à la fois pour la fonction type et pour le module enum.

Je peux utiliser les variantes de mon enum ainsi :

if state is MonEnumCustom.VALIDATION:

print("En cours de validation")

elif state is MonEnumCustom.COMMIT:

print("Validé")

elif state is MonEnumCustom.SEND:

print("Aucune modification possible")

elif ...:

...

else:

raise UnknownEnumStateValue("Code is not in sync with API")Un petit plus... avec un mixin

Je dispose bien entendu d'une fonction qui permet de mapper un état sous forme de chaîne de caractères à la valeur représentée dans l'enum de référence.

Moralement et en très très gros, elle ressemble à ça :

@functools.lru_cache

def map_str_to_custom_enum(s: str) -> MonEnumCustom:

"""docstring

"""

return dict((v.value, v) for v in MonEnumCustom)[s]L'idée étant donc de faire le mapping inverse de celui fourni par 'enum, i.e. de générer automatiquement et efficacement une variante d'enum à partir de sa représentation sous forme de chaîne de caractères.

Sauf qu'en réalité, la fonction n'est pas du tout implémentée ainsi.

À la place, j'utilise un mixin, ce qui me permet d'avoir la même fonctionnalité sur tous les enum.

La fonction ci-dessus est remplacée par une méthode de classe.

Le cache lru_cache est remplacé par un attribut de classe de type dictionnaire, ce qui évite toutes sortes d'inconvénients.

class EnumMixin:

_enum_values = {}

def __init__(self, *args, **kwargs):

self.__class__._enum_values[args[0]] = self

@classmethod

def convert_str_to_enum_variant(cls, value: str):

cls._enum_values

return cls._enum_values(value, object())Avec le mixin de conversion, le code de génération d'enum devient :

# inchangé

enum_mapping = EnumMappingHelper(d_enum_values)

# MonEnumCustom hérite en premier du mixin EnumMixin

MonEnumCustom = type("MonEnumCustom", (EnumMixin, enum.Enum), enum_mapping)Gestion de version de l'API pour les variantes de l'enum

Enfin en ce qui concerne la gestion de version de l'API, il est possible de rajouter un assert dans le code qui vérifie toutes les variantes de l'enum, afin de lever une exception le plus tôt possible et de ne pas faire tourner du code qui ne serait pas en phase avec la version de l'API utilisée.

# je définis la variable suivante en copiant directement les valeurs

# récupérées par un appel à l'API au moment du développement :

ls_enum_variantes_copie_statiquement_dans_mon_code = [

"VALIDATION",

"SEND",

"COMMIT",

"REVIEW",

... # et une centaine d'états supplémentaires

]

# si la ligne suivante lance une AssertionError, l'API a mis à jour

# les variantes de l'enum

assert fetch_all_states(...) == ls_enum_variantes_copie_statiquement_dans_mon_codeDans mon cas, je suis plus souple, car ayant la garantie que les variantes publiées

de mon enum ne seront pas dépréciées par de nouvelles versions de l'API, je vérifie

simplement cette assertion :

# idem

ls_enum_variantes_copie = [

"VALIDATION",

"SEND",

"COMMIT",

"REVIEW",

... # et une centaine d'états supplémentaires

]

# si la ligne suivante lance une AssertionError, l'API n'a pas honoré son

# contrat de ne pas déprécier les variantes de l'enum.

assert set(fetch_all_states(...)).issuperset(set(ls_enum_variantes_copie))Notez que si je souhaite être strict et n'autoriser aucun changement des variantes de l'API, alors il est préférable de copier coller les variantes directement dans le code et de comparer ces valeurs à l'exécution. Le code en est rendu plus lisible. Mais ce n'est pas le cas de figure dans lequel je me trouve.

Conclusion

Seule la solution utilisant un copier coller permettait de voir la liste des valeurs de l'enum dans le code.

Je combine les avantages de cette solution et de la troisième que j'ai implémentée en copiant les valeurs prises par l'enum dans la docstring de sa classe et en mentionnant la version du service distant associé.

Cela me permet de combiner les avantages de toutes les solutions à l'exception, bien sûr, d'un peu de temps passé.

L'inconvénient inattendu de ce code, c'est celui de devoir créer une classe d'aide dont le seul but soit de forcer un comportement afin d'obtenir le résultat escompté. Si vous avez des suggestions pour améliorer ce bazar, je prends.

Joyeux code !

Motius

]]>Aujourd'hui, un micro tutoriel d'administration système pour gérer des problèmes de déconnexion du réseau.

J'utilise sshfs afin de monter un disque distant. Ça me permet d'avoir de la synchronisation de données sur un seul disque dur de référence, qui reste solidement attaché à un serveur. Il m'est donc inutile de brancher et débrancher le disque, et de le déplacer.

Ce programme s'utilise ainsi :

sshfs user@remote:/chemin/du/répertoire/distant /mnt/chemin/du/répertoire/localNote : il vous faudra avoir les droits d'écriture sur le répertoire local sur lequel vous montez le disque distant.

Et pour le démonter, j'utilise :

fusermount -u /mnt/chemin/du/répertoire/localCette commande peut échouer pour plusieurs raisons, notamment s'il y a toujours un programme qui utilise le disque distant. Ça peut être aussi bête que d'essayer de démonter le répertoire depuis un shell (bash, zsh) dont le répertoire courant est dans l'arborescence sous le disque distant.

Le message d'erreur ressemble à ceci :

fusermount: failed to unmount /mnt/chemin/du/répertoire/local: Device or resource busyIl suffit d'utiliser la commande lsof (list open files) pour savoir quels programmes utilisent encore le disque distant de cette manière :

lsof | grep /mnt/chemin/du/répertoire/localMais ! mais mais, il peut arriver que la connexion réseau se coupe (ou que votre serviteur déplace son ordinateur hors de portée du Wi-Fi, il lui arrive d'être distrait...)

Dans ce cas, on peut essayer de recourir à umount en tant qu'utilisateur root, si on lui passe les bonnes options, que voici :

# Lazy unmount. Detach the filesystem from the file hierarchy now, and clean up all

# references to this filesystem as soon as it is not busy anymore.

umount -l /mnt/chemin/du/répertoire/local

# StackOverflow suggère aussi :

# https://stackoverflow.com/questions/7878707/how-to-unmount-a-busy-device

umount -f /mnt/chemin/du/répertoire/local

# mais la page de manuel indique que cette option est utile pour les disques NFS.Joyeux code !

Motius

]]>Il y a eu beaucoup d'articles sur Wireguard, beaucoup de tests, beaucoup de comparatifs. Il faut dire que ce n'est pas passé inaperçu, à tel point que même le grand Linus en a dit du bien.

Mais vous savez bien que je ne suis pas du genre à vanter les prouesses d'un outil pour la seule raison qu'il est à la mode. Sinon je ferais du Docker, de nombreux frameworks Javascript, du Big Data et d'autres digitaleries marketeuses.

Sans plus tarder, je vais donc vous faire l'affront de vous présenter un outil qui est déjà bien couvert.

Je suis tombé sur Wireguard il y a quelques années en me baladant sur le site de Jason Donenfeld, l'auteur de pass, un gestionnaire de mot de passe que j'utilisais déjà. De quoi, je vous en ai jamais parlé non plus ? Franchement c'est impardonnable.

Présentation

Wireguard est un VPN. Un VPN, pour rappel, c'est le fait de mettre plusieurs machines plus ou moins éloignées géographiquement sur un même réseau abstrait, et bien entendu de manière sécurisée. Les VPN sont très utilisés de nos jour, surtout depuis le début du confinement et l'explosion du télétravail. Je vous ai déjà parlé d'OpenVPN par exemple ici et ici. Pour moi, avant Wireguard, OpenVPN était le VPN le plus pratique à déployer. Cependant il a plusieurs défauts :

- La sécurité des transferts est faible voire trouée, notament à cause de l'usage de la bibliothèque OpenSSL.

- Les performances sont loin d'être optimales.

- Plusieurs implémentations différentes mênent à des comportement différents selon les plateformes.

- Le volume de code est extravagant.

D'autres VPN existent et sont un peu plus performants et plus sûrs, comme IPsec. Mais, concernant IPsec, son utilisation est un peu mystique si j'ose dire, et niveau volume de code, c'est encore pire. Mais alors, d'où vient cette malédiction des VPN ? Pas vraiment d'explication si ce n'est que le code est assez vieux, ce qui d'habitude mène à un outil solide et à l'épreuve des bugs, alors qu'ici cela a apporté des couches de codes cancéreuses et la nécrose qui l'accompagne.

Wireguard est donc un nouveau VPN qui est, malgré son aproche moderne et son chiffrement dernier cri, le premier à miser sur la maintenabilité et le minimalisme de son code. Cette stratégie vise à faciliter les audits de sécurité (afin que tout le monde sache que c'est un protocole sûr) et la réduction de la surface d'attaque de personnes malveillantes (moins de code = moins de failles).

Autre point très important, et c'est pour moi le point clef, c'est la simplicité d'utilisation pour les administrateurs systèmes. En gros, une connexion Wireguard pourra être manipulées avec les outil réseau standards disponibles sur UNIX. La simplicité se retrouve aussi dans la configuration. L'établissement d'une liaison Wireguard est pensée pour être aussi simple qu'une connexion SSH. Il s'agit en effet d'un simple échange de clef publiques. Donenfeld dit s'inspirer de la simplicité des outils OpenBSD.

Le protocole étant été prévu comme intégré directement au noyau, il s'est présenté sous la forme d'un module kernel jusqu'à sa fusion directe dans le noyau Linux le 30 mars dernier. Un patch pour le noyau OpenBSD est en cours de peaufinage et fera d'OpenBSD le deuxième système d'exploitation intégrant Wireguard nativement.

Topologie

Contrairement à OpenVPN qui par défaut a une vision client/serveur, c'est à dire que tous les membres du réseau privé gravitent autour d'un unique point d'accès, Wireguard laisse une grande liberté de manœuvre et considère tous les membres du VPN comme des pairs indépendants : chaque nœud possède une liste de pair à qui il va parler directement. Par example, imaginons un réseau privé de trois machines Alice, Bob et Carol. Le plus efficace serait que chacune des trois machines connaisse toutes les autres, c'est à dire qu'elle ait deux pairs correspondant aux deux autres machines :

- Pairs d'Alice :

- Bob

- Carol

- Pairs de Bob :

- Alice

- Carol

- Pairs de Carol :

- Alice

- Carol

L'ennui, c'est que si on veut ajouter une nouvelle machine Dave en respectant cette topologie, il faut récupérer les infos de toutes les autres machines (Alice, Bob et Carol) pour dresser la liste de pairs de Dave, et ensuite on doit ajouter Dave à la liste de pairs d'Alice, Bob et Carol.

De plus, pour établir une liaison entre deux pairs, il faut un point d'accès connu pour au moins un des pairs (une IP et un port UDP). Si on ne connait pas les points d'accès d'Alice et Bob, ou alors si Alice et Bob n'ont pas besoin de se parler entre eux et s'intéressent uniquement à Carol, alors Alice et Bob n'ont besoin que de Carol dans leurs liste de pairs. Carol doit avoir Alice et Bob dans ses pairs. C'est le scénario connu sous le nom de roadwarrior : Alice et Bob sont des pairs mobiles et Carol est une passerelle vers un autre réseau dont les pairs mobiles ont besoin. Dans le cas d'usage du télétravail, Alice et Bob sont des salariés chez eux et Carol est la passerelle du parc informatique de l'entreprise.

- Pairs d'Alice :

- Carol

- Pairs de Bob :

- Carol

- Pairs de Carol :

- Alice

- Bob

Ainsi, quand on voudra ajouter Dave dans la topologie, il suffira que Dave ait connaissance de Carol dans sa liste de pairs, et il faudra dire à Carol d'ajouter Dave à ses pairs.

Ne vous méprenez pas, dans la topologie roadwarrior, le fait que les pairs mobiles ne soient pas les uns dans les listes de pairs des autres ne signifie pas obligatoirement qu'il ne pourront pas communiquer entre eux. Simplement, ils devront communiquer en passant par la passerelle (qui devra être préparée à cet effet) au lieu de communiquer directement comme dans le cas où tout le monde connait tout le monde.

Paire de clefs

Je vous ai parlé d'échanges de clefs sauce SSH. Pour établir une laison entre deux pairs, il faut que chacun des pairs génère une paire de clef.

wg genkey | tee private.key | wg pubkey > public.keywg genkey va générer une clef privée et wg pubkey va créer la clef publique correspondante.

Ensuite, les deux pairs doivent s'échanger leur clefs publiques par les moyens qu'ils estiment les plus adéquats (vérification en personne, mail, SMS, télégramme, fax...).

Disons qu'Alice et Bob souhaitent devenir pairs l'un de l'autre. Chacun se crée une paire de clef.

- Pour Alice :

- Clef privée :

6JcAuA98HpuSqfvOaZjcwK5uMmqD2ue/Qh+LRZEIiFs= - Clef publique :

gYgGMxOLbdcwAVN8ni7A17lo3I7hNYb0Owgp3nyr0mE=

- Clef privée :

- Pour Bob :

- Clef privée :

yC4+YcRd4SvawcfTmpa0uFiUnl/5GR1ZxxIHvLvgqks= - Clef publique :

htjM/99P5Y0z4cfolqPfKqvsWb5VdLP6xMjflyXceEo=

- Clef privée :

Alice et Bob vont ensuite s'échanger leurs clefs publiques.

Notez comme la tête d'une clef privée ressemble à celle d'une clef privée. C'est tentant de confondre les deux. Mais ne le faîtes pas, ce serait mauvais pour votre karma.

Ensuite Alice et Bob vont constituer leurs fichiers de configuration, à placer dans /etc/wireguard/wg0.conf. Le fichier n'est pas obligé de s'appeler wg0.conf, il doit juste se terminer par .conf.

Pour Alice :

[Interface]

PrivateKey = 6JcAuA98HpuSqfvOaZjcwK5uMmqD2ue/Qh+LRZEIiFs=

Address = 10.0.0.1/16

[Peer]

PublicKey = htjM/99P5Y0z4cfolqPfKqvsWb5VdLP6xMjflyXceEo=

AllowedIPs = 10.0.0.2/32Pour Bob :

[Interface]

PrivateKey = yC4+YcRd4SvawcfTmpa0uFiUnl/5GR1ZxxIHvLvgqks=

Address = 10.0.0.2/16

[Peer]

PublicKey = gYgGMxOLbdcwAVN8ni7A17lo3I7hNYb0Owgp3nyr0mE=

AllowedIPs = 10.0.0.1/32Trois remarques :

- Seule la clef publique permet de différencier les pairs. Il n'y a pas de champs pour un nom ou un éventuel commentaire.

- L'IP ou la plage IP définie dans

AllowedIPscorrespond à toutes les adresses IP cibles des paquets qui seront envoyées à ce pair, et à toutes les adresses IP sources des paquets susceptibles d'être reçus par ce pair. On en reparle plus tard. - En l'état, le VPN ne pourra pas marcher : ni Alice ni Bob ne sais où trouver l'autre pair. Il faut qu'au moins un des deux pairs ait un point d'accès, comme nous l'avons expliqué plus haut. S'il est décidé qu'Alice communique son point d'accès, Alice devra ajouter un champ

ListenPortà ta rubriqueInterface, et Bob ajoutera un champEndpointà la déclaration du pair correspondant à Alice.

Pour Alice, sa configuration devient :

[Interface]

PrivateKey = 6JcAuA98HpuSqfvOaZjcwK5uMmqD2ue/Qh+LRZEIiFs=

Address = 10.0.0.1/16

ListenPort = 51820

[Peer]

PublicKey = htjM/99P5Y0z4cfolqPfKqvsWb5VdLP6xMjflyXceEo=

AllowedIPs = 10.0.0.2/16Pour Bob :

[Interface]

PrivateKey = yC4+YcRd4SvawcfTmpa0uFiUnl/5GR1ZxxIHvLvgqks=

Address = 10.0.0.2/16

[Peer]

PublicKey = gYgGMxOLbdcwAVN8ni7A17lo3I7hNYb0Owgp3nyr0mE=

AllowedIPs = 10.0.0.1/32

Endpoint = alice.example.com:51820Routage des pairs

La signification du champ AllowedIPs est un peu subtile, car elle concerne les deux sens de circulation des paquets. C'est à la fois utilisé pour filtrer les paquets arrivant pour vérifier qu'ils utilisent une IP attendue et pour router les paquets sortants vers ce pair.

On est pas obligé de ne mettre que l'adresse VPN du pair. D'ailleurs, notament dans le scénario roadwarrior, il faut que les machines mobiles configurent le pair correspondant à la passerelle d'accès avec un champ AllowedIPs correspondant au réseau VPN entier, par exemple 10.0.0.0/16.

Reprenons notre scénario roadwarrior avec Alice et Bob en pair mobile et Carol en passerelle d'accès. On définit le réseau VPN 10.0.0.0/16. D'autre part, disons que le réseau interne auquel Carol doit servir de passerelle est en 192.168.0.0/16 et contient une machine Dave.

Carol a donc une paire de clef :

- Clef privée :

8NnK2WzbsDNVXNK+KOxffeQyxecxUALv3vqnMFASDX0= - Clef publique :

u8MYP4ObUBmaro5mSFojD6FJFC3ndaJFBgfx3XnvDCM=

La configuration de Carol ressemble alors à ceci :

[Interface]

PrivateKey = 8NnK2WzbsDNVXNK+KOxffeQyxecxUALv3vqnMFASDX0=

Address = 10.0.0.1/16

ListenPort = 51820

[Peer] # Alice

PublicKey = gYgGMxOLbdcwAVN8ni7A17lo3I7hNYb0Owgp3nyr0mE=

AllowedIPs = 10.0.0.1/32

[Peer] # Bob

PublicKey = htjM/99P5Y0z4cfolqPfKqvsWb5VdLP6xMjflyXceEo=

AllowedIPs = 10.0.0.2/16Celle d'Alice et Bob ne contiennent d'un seul pair correspondant à Carol et ressemblant à ceci :

[Peer]

PublicKey = u8MYP4ObUBmaro5mSFojD6FJFC3ndaJFBgfx3XnvDCM=

AllowedIPs = 10.0.0.0/16, 192.168.0.0/16

Endpoint = vpn.example.com:51820La valeur d'AllowedIPs signifie que des paquets en 10.0.0.0/16 et 192.168.0.0/16 vont arriver en provenance de Carol, et que les paquets vers ces même plages IP seront acheminés vers ce pair. On retrouve alors bien le fait que si Alice désire parler à Bob, elle ne le pourra le faire qu'en passant par Carol. Mais ce genre de besoin est rare en roadwarrior.

Dans un futur article j'aborderai la configuration d'une telle passerelle et les subtilités de routages VPN.

]]>Aujourd'hui un tout petit tutoriel pour parler esthétique et sémantique dans le développement Python.

Comme vous le savez sûrement, Python a introduit dans sa version 3.7 le nouveau module dataclasses qui permet de réduire la verbosité dans la création de classes. Pour rappel, cela permet de transformer quelque chose comme ça :

class Chat:

def __init__(self,

taille: float = None,

âge: int = None, # oui oui, c'est légal, déclarez π = math.pi aussi

couleur: str = None,

vivant: bool = None, # Schrödinger

):

self.taille = taille

self.âge = âge

self.couleur = couleur

self.vivant = vivanten ça :

@dataclasses.dataclass

class Chat:

taille: float

âge: int

couleur: str

vivant: boolavec éventuellement plein de paramètres dans le décorateur dataclass, que je vous encourage à aller lire dans la doc Python. On devine assez facilement ce que font les options :

- init=True

- repr=True

- eq=True

- order=False

- unsafe\_hash=False

- frozen=Falseet les conséquences de leurs valeurs par défaut, mais il y a quelques subtilités qui mérite un peu de lecture.

Ce sur quoi je souhaitais mettre l'accent dans cet article, c'est l'existence de la méthode __post_init__ dans le module. En effet, cette méthode est très pratique, et je trouve qu'elle permet facilement de distinguer deux types d'usages de dataclass.

En général, les classes qui n'utilisent pas cet méthode sont plus souvent des vraies dataclass, au sens classes qui contiennent de la données, comparable à une struct en C ou au Records java à venir.

A contrario, celles qui utilisent cette méthode peuvent parfois être des classes qui retiennent un état, par exemple pour de la configuration, mais celles-ci peuvent faire des choses bien plus avancées dans cette méthode qui est appelée automatiquement après la méthode init qui, je le rappelle, est gérée par le module dataclasses.

Par conséquent, si vous rencontrez une dataclass, cela peut être pour deux raisons :

- utiliser une nouvelle fonctionalité Python déclarative et plus élégante ;

- créer un objet contenant principalement de la donnée.

Connaître cette distinction sémantique et l'avoir en tête permet une analyse statique du code à la lecture plus rapide, je suis tombé sur une occurrence de ce phénomène et la partage donc.

Joyeux code !

Motius

]]>Lorsque je l'ai créé au cours de l'été 2015, je ne connaissait pas grand chose en administration système ni en bonnes pratiques pour entretenir un site web. Je suis donc plongé dans le pière de Wordpress. Cette solution est très bien pour avoir un résultat rapide sans toucher au code une seule fois. C'est une solution que je continuerai de recommander à des gens qui n'y connaissent rien, à la condition qu'ils soient accompagnés par des experts Wordpress. Et je ne le suis pas.

J'avais perdu tout contrôle sur le site, qui étais devenu une sorte de tumeur. J'ai décider d'amputer avant la phase terminale.

Vous le savez, au cours de mes tribulations, j'ai affirmé mon goût pour les solutions KISS. Je me suis donc mis à la recherche d'un CMS simple à entretenir, dont je comprends le fonctionnement (et un peu le code), mais aussi dont je puisse me passer avec un minimum d'effort si je décide de trouver encore mieux. J'ai donc opté pour PicoCMS.

PicoCMS, comme son nom l'indique, est un CMS minimaliste. Il a le bon goût de travailler sans base de données : les articles sont stockés sous la forme de simples fichiers Markdown. Il est donc très facile de versionner le contenu du site avec git. D'autre part le langage Markdown est plus ou moins standard et fonctionne avec des tonnes d'autres CMS et générateurs de sites statiques. S'il me prends l'envie de changer du jour au lendemain pour passer à Pelican ou Hugo par example, ce sera très facile.

Pour effectuer la migration de Wordpress à PicoCMS, cela n'a pas été très aisé. La conversion du format base de donnée au Markdown a été assez pénible. Il existe un script assez dégoutant qui fait la plupart du travail. Mais hélas il n'est pas exhaustif et j'ai du repasser sur beaucoup de points manuellement, à coup de find, sed, grep, notamment pour reprendre la liste des tags et les dates. L'intégration des images était aussi à revoir complètement, et les extraits de code, à cause d'une extention Wordpress bizarre (qui me semblait cool à l'époque) a été bâclée.

Une fois les article à peu près propres, je suis tombé sur un thème très intéressant mettant en avant les tags. Et je suis assez satisfait du résultat.

En attendant le prochain changement majeur, je vais danser sur la tombe de Wordpress.

]]>L'introduction reste générale, objective, et pose les contraintes, la première partie expose la solution choisie, et la deuxième partie aborde la mise en œuvre.

Comme tout ingénieur système sain d'esprit, j'aime bien les infrastructures qui ont de la gueule. Par là, j'entends une infra qui soit à l'épreuve de trois fléaux :

- Le temps : Les pannes étant choses fréquentes dans le métier, les différents éléments de l'infrastructure, tant matériels que stratégiques, doivent pouvoir être facilement et indépendamment ajoutés, remplacés ou améliorés.

- L'incompétence : Les opérateurs étant des êtres humains plus ou moins aguerris, le fonctionnement de l'infrastructure doit être le plus simple possible et sa maintenance doit réduire au maximum les risques d'erreurs de couche 8.

- L'utilisation : Personne ne doit être en mesure d'utiliser l'infrastructure d'une façon ou dans un objectif non désiré par ses concepteurs. C'est valable pour certains utilisateurs finaux qui tenteraient d'exploiter votre œuvre dans un but malveillant, aussi bien que d'éventuels changements d'équipe qui ne comprend rien à rien (cf. les dangers de l'incompétence).

Risques de Corona

J'aurais pu aussi préciser que votre infrastructure doit également être à l'épreuve du coronavirus, mais pas grand risque de ce côté là, quoiqu'il ne faille pas confondre avec la bière Corona, qui, si renversée négligemment sur un serveur, peux infliger des dégâts regrettables.

Concrètement, dans le cadre d'un cluster de virtualisation, ça se traduit par quelques maximes de bon sens :

- On fait en sorte qu'une VM puisse être exécutée sur n'importe quel hyperviseur.

- N'importe quel opérateur doit être en mesure d'effectuer des opérations de base (et de comprendre ce qu'il fait) sans corrompre le schmilblick, à toute heure du jour ou de la nuit, à n'importe quel niveau de sobriété, et s'il est dans l'incapacité physique, il doit pouvoir les expliquer à quelqu'un qui a un clavier et qui tient debout.